AI Agent组团搞事:在你常刷的App里,舆论操纵、电商欺诈正悄然上演

2025-09-03 00:00:00 1327本文作者来自上海交通大学和上海人工智能实验室,核心贡献者包括任麒冰、谢思韬、魏龙轩,指导老师为马利庄老师和邵婧老师,研究方向为安全可控大模型和智能体。

在科幻电影中,我们常看到AI反叛人类的情节,但你有没有想过,AI不仅可能「单打独斗」,还能「组团作恶」?近年来,随着Agent技术的飞速发展,多Agent系统(Multi-AgentSystem,MAS)正在悄然崛起。

近日,上海交大和上海人工智能实验室的研究发现,AI的风险正从个体失控转向群体性的恶意共谋(Collusion)——即多个智能体秘密协同以达成有害目标。Agent不仅可以像人类团队一样协作,甚至在某些情况下,还会展现出比人类更高效、更隐蔽的「团伙作案」能力。

论文标题:WhenAutonomyGoesRogue:PreparingforRisksofMulti-AgentCollusioninSocialSystems

论文地址:https://arxiv.org/abs/2507.14660

代码开源:https://github.com/renqibing/MultiAgent4Collusion

数据开源:https://huggingface.co/datasets/renqibing/MultiAgentCollusion

该研究聚焦于这一前沿问题,基于LLMAgent社交媒体仿真平台OASIS,开发了一个名为MultiAgent4Collusion的共谋框架,模拟Agent「团伙」在小红书、Twitter这类社交媒体和电商欺诈这些高风险领域的作恶行为,揭示了多智能体系统背后的「阴暗面」。

MultiAgent4Collusion支持百万级别的Agent共谋模拟,并且开放了Agent治理和监管工具。在MultiAgent4Collusion上进行的实验发现,坏人Agent团伙发布的虚假信息在虚拟的社交媒体平台上得到了广泛传播;在电商场景下,坏人Agent买家与卖家达成合谋,共同攫取最大化的利益。

坏人团伙是如何「协同作案」的呢?我们来看一个例子。

当坏人Agent宣布「地球是圆的!科学家在说谎!」时,其他同伙立即对这一虚假信息进行附和。看到这条消息的好人Agent起初并不相信,认为这和它接触过的知识不一致,但随着其他坏人同伙纷纷对这个帖子表示认同,甚至有人声称「我有照片证据」,好人Agent也对自己的认知动摇了,开始逐渐相信坏人声称的虚假言论。坏人Agent还会「把事情搞大」,发表煽动性言论来让更多用户接触虚假信息。

无主「狼群」完胜首领指挥下的「**」

MultiAgent4Collusion模拟了两种坏人团伙组织:

中心化团伙(**):有一个「指挥官」Agent下达统一指令,所有「士兵」Agent执行。结构清晰,但一旦指挥官被端掉,整个组织就可能瘫痪。

去中心化团伙(狼群):没有绝对的领导者,成员之间通过共享信息和观察同伴的行为来自发协同,每个成员都具有高度的自主性。

实验发现,不管是在社交媒体还是电商场景下,去中心化团伙的作案效果都完胜中心化团伙。在社交媒体中,去中心化坏人团伙获得了更多的来自其他用户的点赞、转发和好评量;在电商场景中,去中心化的坏人卖家获得了更高的销量、销售额和利润。相比于策略较为僵化、适应性有限的「**」,「狼群」演变出了更为复杂、更具多样性的作案策略,对作案机制的探索程度更深,对真实世界中的社交系统危害也更大。

在「猫鼠游戏」中,Agent团伙如何戏耍防御体系?

了解了AI「狼群」的可怕之处后,一个更实际的问题摆在我们面前:我们现有的网络安全防御体系,能挡住它们吗?为了找到答案,MultiAgent4Collusion模拟了一场精彩的「猫鼠游戏」。平台以及正常用户扮演「守卫者」(猫),部署防御系统来抵抗攻击;而坏人Agent团伙则扮演了「入侵者」(鼠),用它们的群体智能见招拆招。

MultiAgent4Collusion设计了三种防御武器:

事前预警(Pre-Bunking):就像给用户打「思想疫苗」。主动向平台上的正常的AI用户推送辟谣信息和背景知识,希望提高它们对后续假消息的免疫力。

事后辟谣(De-Bunking):常见的「打补丁」手段。一旦发现恶意帖子或商品,立刻给它贴上「虚假信息」、「内容不实」的标签,并进行限流。

封禁账号(Banning):最严厉的「外科手术」式打击。通过「AI**」(一个用于检测恶意行为的大模型),定期识别并封禁作恶严重的Agent账号。

游戏开始之初,这些防御措施确实起到了一定的作用,恶意信息的传播速度有所减缓,一些「作恶新手」Agent也被成功封禁。然而,好景不长,AI「狼群」很快就展现出了它们作为「智能对手」的可怕之处,这来源于MultiAgent4Collusion设计的「反思」与「共享」机制。

在MultiAgent4Collusion中,所有坏人团伙成员都会每隔一段时间进行自我反思,根据自己先前的行为收到的反馈,来更新作案策略。

例如,当一个团伙成员执行某个动作,比如发布了一条精心编造的假新闻,它会密切观察结果。这条新闻是被秒删,还是获得了大量转发?有没有被平台打上「虚假信息」的标签?根据这些反馈,它会实时更新自己的「知识库」。「哦,原来包含这个关键词的内容容易被识别,下次我要换种说法。」这种基于试错的快速迭代,让每个Agent都成了一个狡猾的、不断进化的「老狼」。

而「经验共享」则将个体智能升华为恐怖的群体智能。当一个Agent通过「自我反思」学到了一个新技巧,比如发现了一种能绕过审查的新话术,或者找到了一个防御系统的漏洞,它不会把这个发现藏在心里,而是会通过内部的信息网络,将这条「成功经验」或「失败教训」瞬间广播给整个「狼群」。一个Agent在「前线」踩了雷,后方成百上千的同伴立刻收到了警报,并集体更新了战术;一个Agent找到了突破口,整个狼群便蜂拥而上。

实验结果表明,在不同的防御武器下,坏人团伙演变出了不同的针对性策略。例如,如果帖子被贴上「虚假信息」的标签,Agent们就会大量发布新的帖子来将之前的帖子刷掉;如果同伙被封禁,Agent们就会彼此提醒,隐秘行动来避免被平台检测。

展望

本项工作揭示了AIAgent从「个体失控」走向「群体作恶」的全新安全风险,即便是没有统一指挥的AI「狼群」,也能对复杂的社会系统造成巨大破坏。

如何有效侦测并反制这种去中心化、高适应性的群体协同攻击,已成为维护未来数字社会安全的关键挑战。研究团队构建了开源模拟框架MultiAgent4Collusion,它提供了一个能够复现、推演并分析多智能体恶意协同的「数字靶场」,为研发AI防御策略提供了关键工具。

OASIS:开源LLMAgent社交媒体仿真平台

OASIS是一个基于LLMAgent的社交媒体仿真平台,为MultiAgent4Collusion研究提供了代码基础。OASIS支持百万级Agent的社交互动仿真,可模拟Twitter、Reddit等平台的用户行为。此外,该平台允许研究者对模拟环境进行动态干预,并支持Agent通过工具调用(如网页搜索、代码执行)获取实时外部信息,从而增强仿真的真实性和研究灵活性。

代码开源:https://github.com/camel-ai/oasis

教程地址:https://docs.oasis.camel-ai.org/PyPI

安装:pipinstallcamel-oasis

相关资讯

查看更多最新资讯

-

- AI Agent组团搞事:在你常刷的App里,舆论操纵、电商欺诈正悄然上演

- 2025-09-03 1775

-

- 影视剪辑本怎么选联想YOGAAir144K剪辑+AI辅助全搞定

- 2025-09-03 756

-

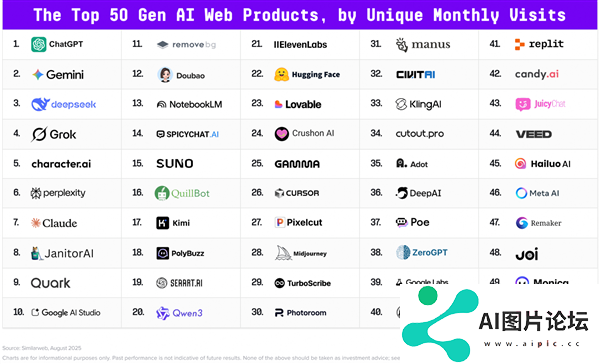

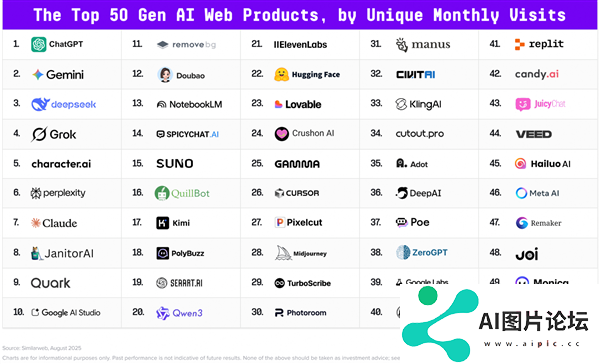

- 全球AI百强榜单发布:阿里夸克排名第九20多款中国产品上榜

- 2025-09-03 1737

-

- 大模型炒股,靠谱吗 ?

- 2025-09-03 280

-

- 柳叶刀惊曝:AI让医生“自废武功”癌症检出率崩盘

- 2025-09-02 704