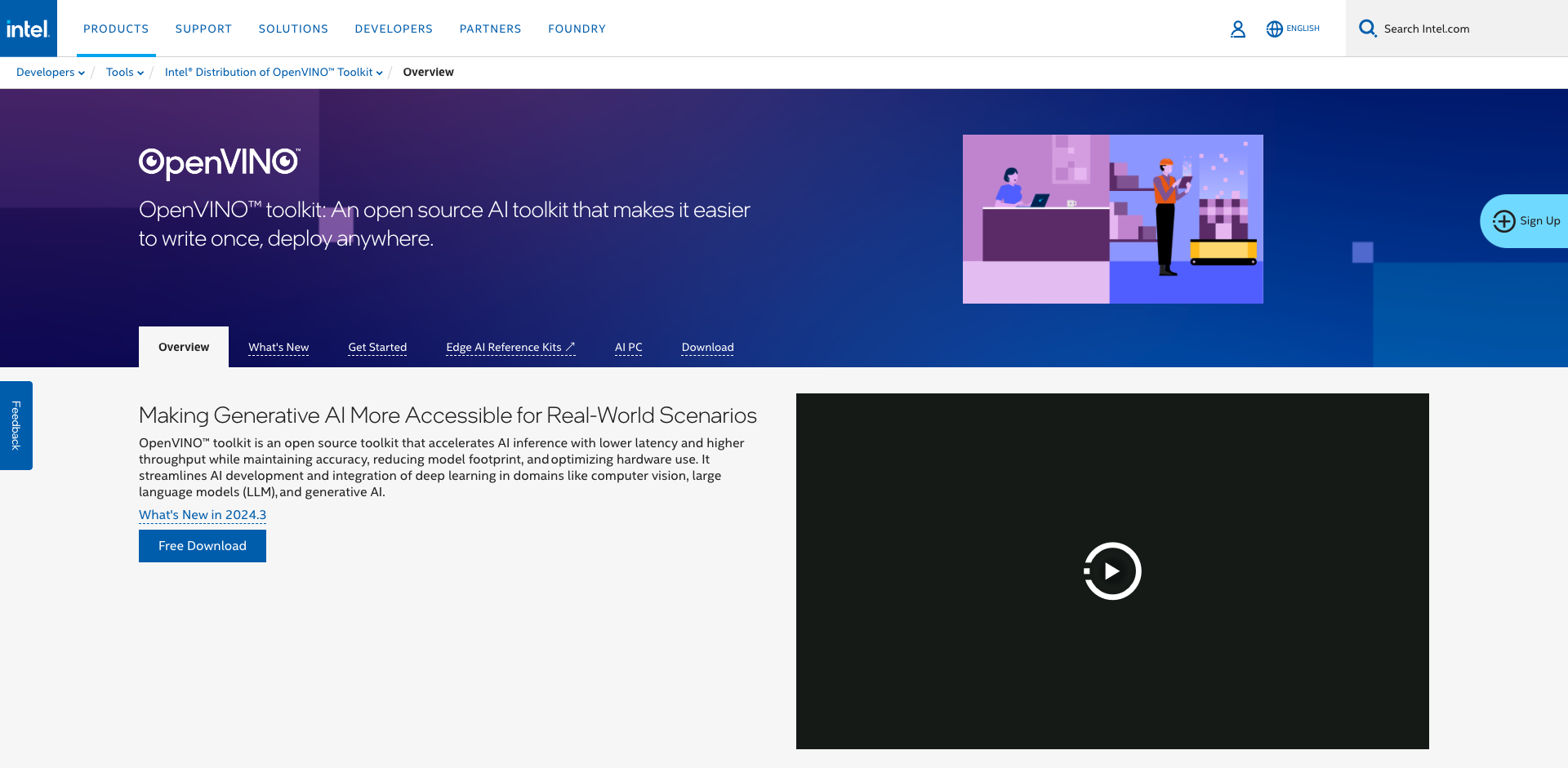

OpenVINO入门学习资料汇总 - 开源AI推理加速与优化工具包

2024-12-17 00:00:00 951

OpenVINO简介

OpenVINO™(Open Visual Inference and Neural network Optimization)是由Intel开发的开源工具包,用于优化和加速深度学习模型的推理。它支持多种深度学习框架,可以在Intel的CPU、GPU、VPU等硬件上高效运行AI模型。

OpenVINO的主要特点包括:

支持多种深度学习框架,如TensorFlow、PyTorch、ONNX等提供模型优化工具,可以压缩模型大小、提高推理速度支持异构计算,可以在CPU、GPU、VPU等硬件上灵活部署提供跨平台支持,可在Windows、Linux、macOS等系统上使用针对Intel硬件进行了深度优化,发挥硬件性能

安装与配置

OpenVINO提供了多种安装方式,最简单的是通过pip安装:

pip install openvino也可以通过Anaconda、Homebrew等方式安装,详细安装步骤请参考官方安装指南。

安装完成后,可以运行以下代码验证安装:

import openvino as ovprint(ov.__version__)快速入门

OpenVINO快速入门教程 - 官方入门指南,介绍基本概念和用法

OpenVINO Notebooks - 包含多个Jupyter notebook示例,涵盖各种应用场景

模型优化指南 - 介绍如何使用OpenVINO优化模型

API文档 - 详细的API参考文档

示例代码

以下是使用OpenVINO进行模型推理的简单示例:

import openvino as ov# 加载模型model = ov.Core().read_model("model.xml")# 编译模型compiled_model = ov.Core().compile_model(model, "CPU")# 准备输入数据input_data = ... # 执行推理results = compiled_model(input_data)更多示例代码请参考官方示例仓库。

社区资源

GitHub仓库 - 源代码、Issue跟踪、贡献指南OpenVINO论坛 - 技术讨论、问答Awesome OpenVINO - 社区项目集合总结

OpenVINO是一个功能强大的AI推理加速工具包,可以帮助开发者优化深度学习模型并在各种硬件上高效部署。本文汇总了OpenVINO的入门学习资料,希望能帮助读者快速上手使用这一工具。随着AI应用的普及,掌握OpenVINO将成为AI开发者的重要技能之一。

相关资讯

查看更多最新资讯

-

- 专家说很多翻译硕士水平比不上AI,但人工智能不会淘汰所有的人工

- 2025-01-15 213

-

- 为什么说“人工智能”这个词不够准确?

- 2025-01-15 260

-

- 新壹科技:2024不断缔造AI视频生产新动能

- 2025-01-15 1858

-

- 人工智能时代,编辑这一传统职业面临怎样的“变”与“不变”

- 2025-01-15 1176

-

- CES 2025开幕在即!Agentic AI或成一大焦点

- 2025-01-15 1527