- 更新时间 2025-01-15

LLocalSearch:本地化大语言模型搜索工具

LLocalSearch是一个创新的项目,它为本地运行的大语言模型(Large Language Models,简称LLMs)提供了一个强大的包装器。这个项目的目标是让较小规模、计算能力相对有限的语言模型也能够像ChatGPT那样智能地回答问题和执行任务。

项目核心功能

LLocalSearch的核心在于允许语言模型从一系列预定义的工具中进行选择。这些工具使模型能够在互联网上搜索最新信息,以回答用户的问题。整个过程是递归的,这意味着运行中的语言模型可以根据从用户和其他工具调用获得的信息,自由选择使用工具,甚至多次使用。

为什么选择LLocalSearch

在当前的AI服务市场中,一些大公司正在推行优先展示付费内容的策略。相比之下,LLocalSearch提供了一个不受商业利益影响的替代方案。它允许用户获得更加中立、不受偏见影响的信息。

突出特性

完全本地化:无需API密钥,更好地保护用户隐私。

硬件要求低:可在配置相对较低的硬件上运行。

实时日志和链接:用户可以更好地理解AI代理的工作过程和信息来源。

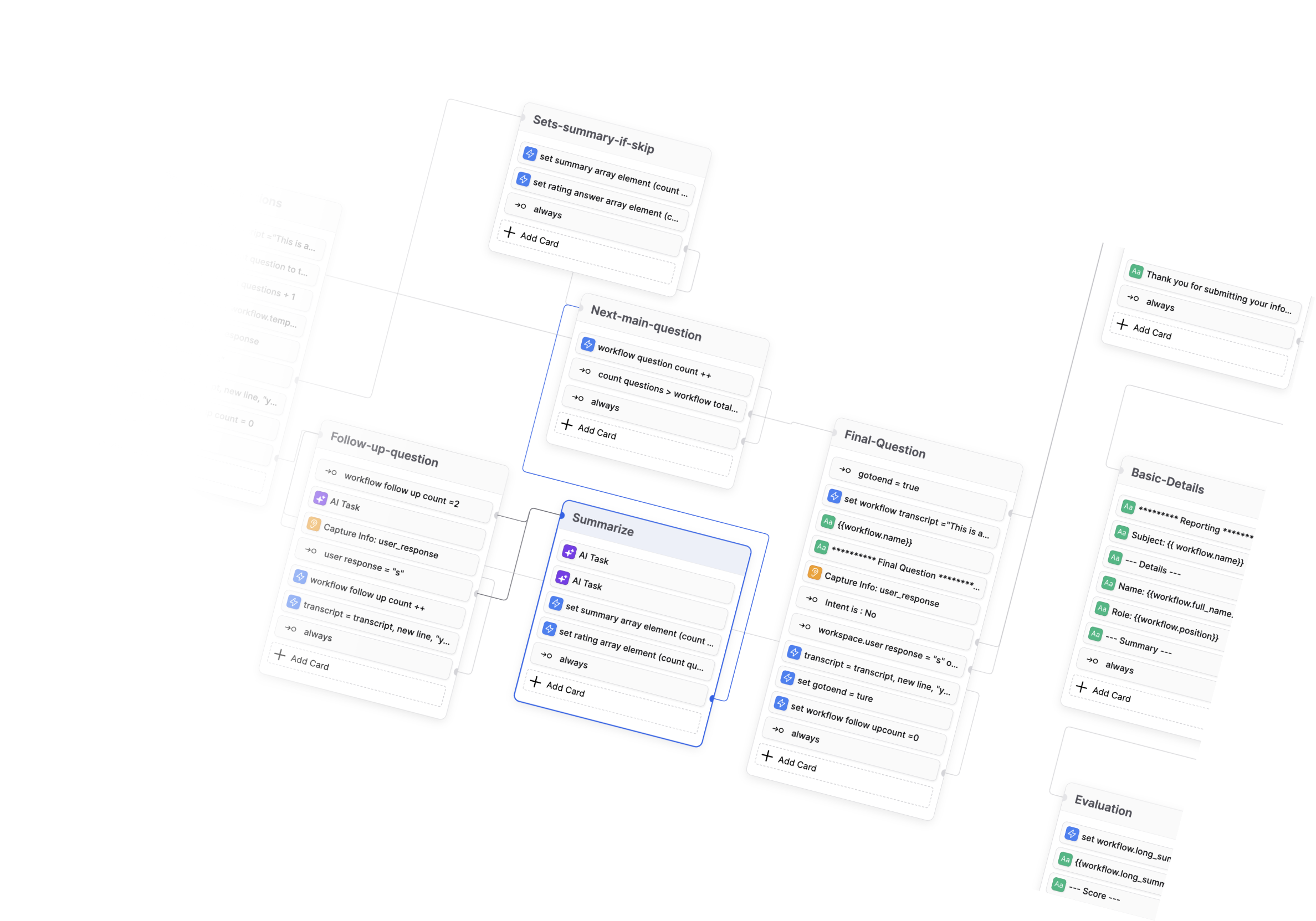

支持后续问题:能够进行连续的对话交互。

移动友好设计:适配各种移动设备。

深色和浅色模式:满足不同用户的界面偏好。

项目发展路线

目前,LLocalSearch团队正在积极开发以下功能:

支持LLama3模型

界面全面改进

聊天历史支持

未来计划包括:

用户账户系统

长期记忆功能

安装指南

LLocalSearch提供了简单的Docker安装方式:

克隆GitHub仓库

创建并编辑.env文件(如需要)

运行Docker容器

通过这种方式,用户可以快速部署并开始使用LLocalSearch。

结语

LLocalSearch为那些寻求更加透明、可控的AI辅助工具的用户提供了一个绝佳的选择。它不仅保护用户隐私,还为用户提供了深入了解AI决策过程的机会。随着项目的不断发展,LLocalSearch有望成为AI辅助研究和信息获取领域的重要工具。

同类推荐

查看更多AI教程资讯

查看更多- 1 Botpress学习资料汇总 - 开源对话式AI平台 10

- 2 BibiGPT-v1: 革命性的AI音视频内容一键总结工具 6

- 3 Ethora: 开源 Web3 社交平台引擎 6

- 4 DouZero: 基于自我对弈深度强化学习的斗地主AI系统 8

- 5 开源数据工程项目精选:打造现代数据基础架构 5

- 6 Chroma 学习资源汇总 - 开源AI原生嵌入式数据库 12

- 7 AI也能刷短视频了?!清华大学最新发布短视频理解模型,含图像文本音频多模态理解 8

- 8 Diffree:最新模型实现文字指令修改图片!!这下修图变得更简单了 4

- 9 北大团队最新发布全景3D技术!只需一张图片和一段话就能生成全景3D场景 4

- 10 React Agent 学习资料汇总 - 开源 React.js 自主 LLM 代理 5